AI Agents 101: Do ETL ao "ECL" (Extract-Contextualize-Load)

Como a Engenharia de Dados se Adapta à Era do Contexto e dos LLMs

Meu nome é Igor Cleto, e obrigado por visitar meu canal.

Neste espaço compartilho o que venho aprendendo a respeito de Dados e Tecnologia de maneira acessível e em português.

Ainda não é inscrito? Inscreva-se no botão abaixo!

O antigo ETL (nos tempos modernos ELT)

Por décadas, a engenharia de dados teve uma espinha dorsal clara: o processo de ETL (Extract, Transform, Load), que evoluiu para o ELT (Extract, Load, Transform) nos tempos mais modernos. Essas metodologias foram fundamentais para mover e organizar dados, principalmente estruturados, de diversas fontes para um único local centralizado – o data warehouse. Lá, essa informação podia ser limpa, transformada (mudando esquemas, agregando, etc.) e carregada, preparando o terreno para análises de BI (Business Intelligence), relatórios, apresentações e alimentar aplicações baseadas em dados estruturados. Se você é Engenheiro de Dados ou Engenheiro de Analytics, está intimamente familiarizado com a construção desses ambientes OLAP (Online Analytical Processing).

No entanto, o mundo dos dados está em constante evolução. E a mudança mais significativa dos últimos tempos veio com a ascensão dos chamados Large Language Models - LLMs, como o ChatGPT.

Isso é suficiente para uma LLM?

A chegada de modelos de IA que entendem e geram texto mudou fundamentalmente a forma como encaramos e trabalhamos com a informação. Antes, nosso foco principal recaía sobre números, categorias e estruturas rígidas de tabelas. Agora, o cenário é muito mais fluido e complexo:

A IA que Entende a Linguagem Humana: Os LLMs possuem uma capacidade notável de analisar documentos e textos que não seguem um esquema fixo: e-mails, relatórios, posts em redes sociais, artigos, transcrições de voz. Eles interagem e processam informação usando linguagem natural.

Dados "Bagunçados" Ganham Valor: Textos livres, antes difíceis de processar em larga escala sem esforço manual massivo, tornaram-se matéria-prima incrivelmente valiosa. Feedback de clientes, transcrições de reuniões, descrições de produtos informais. Tudo isso contém insights riquíssimos, e a IA é a ferramenta que ajuda a extrair sentido dessa "bagunça" textual.

Contexto é Tudo: Para que um LLM não apenas leia um texto, mas o compreenda de forma útil e relevante, ele precisa de contexto. Precisamos "ensinar" ao modelo o significado por trás das palavras e frases em uma situação específica – o que um termo técnico significa naquele domínio, qual a nuance de uma expressão, como interpretar uma gíria ou abreviação. É como dar ao LLM as chaves para pensar de forma mais próxima à humana, entendendo intenções e subentendidos.

A grande lição é clara: dar contexto às palavras e frases que alimentam os LLMs – explicando o que elas realmente significam em cada situação específica é fundamental para que esses modelos entendam melhor as informações e gerem resultados precisos e relevantes.

O que de fato é “contexto” na Era dos LLMs?

Em sistemas que utilizam Large Language Models, "contexto" refere-se a todas as informações adicionais que são fornecidas ao modelo para ajudá-lo a entender a intenção do usuário, o significado preciso dos termos, a relevância da informação e a situação específica em que a interação ocorre. Funciona como uma "camada de fundo" ou um conjunto de "instruções" que orientam o modelo a gerar respostas que são não apenas gramaticalmente corretas, mas também precisas, personalizadas e logicamente consistentes dentro daquele cenário.

Por exemplo:

Se um cliente em um chat de suporte diz "preciso disso urgente", o sistema precisa do contexto do setor ou do tipo de serviço para saber se "urgente" significa 1 hora, 4 horas ou 1 dia. Sem esse contexto, a palavra "urgente" sozinha é ambígua.

Em interações entre sistemas (IA+IA), se um sistema de vendas comunica com um sistema de estoque, ambos precisam "falar a mesma língua contextual". O termo "cliente premium", por exemplo, pode ter diferentes regras e privilégios associados dependendo do departamento – o contexto define qual regra se aplica.

É aqui que surge o conceito de ECL — Extrair, Contextualizar e Carregar. Ele representa um pipeline de processamento de informações otimizado para os desafios e requisitos dos LLMs e das aplicações orientadas a contexto.

ECL em detalhe

Vamos detalhar as etapas do ECL sob esta nova perspectiva:

Extrair (Extract):

Similar ao ETL, a primeira etapa é a recuperação da informação. Contudo, a diferença crucial está na diversidade das fontes (documentos não estruturados, bases de dados, APIs) e no tipo de informação (predominantemente textual e menos rigidamente esquematizada).

Aqui, buscamos identificar e obter os fragmentos de informação (os 'chunks' ou documentos relevantes) que são potencialmente úteis para a tarefa em mãos.

Contextualizar (Contextualize):

Esta é a etapa que define o ECL e o distingue radicalmente do "Transform" tradicional. O objetivo não é apenas reformatar dados, mas sim construir e anexar o contexto à informação extraída.

Neste passo, a informação é processada e enriquecida. Isso pode incluir:

Análise semântica para entender o significado real.

Aplicação de Conhecimento Especializado (Regras Determinísticas): Incorporar regras de negócio e heurísticas definidas por especialistas para interpretar, classificar ou priorizar a informação com base em conhecimento prévio (ex: aplicar a regra do prazo "urgente" para um setor específico).

Integração de Memória e Personalização: Usar o histórico de interações do usuário, suas preferências ou o estado atual da sessão para filtrar, adaptar ou refinar a informação, tornando-a relevante para aquele usuário específico.

A etapa de Contextualizar transforma dados extraídos em conhecimento pronto para ser interpretado e utilizado de forma inteligente por um LLM, garantindo que ele opere com a camada de fundo contextual necessária.

Carregar (Load):

A etapa final é disponibilizar a informação contextualizada para a entidade que a consumirá – tipicamente um LLM que precisa gerar uma resposta, ou outro sistema que precisa tomar uma decisão.

O "Carregar" no ECL não significa apenas armazenar em um data warehouse, mas sim preparar a informação no formato e local certo para uso imediato. Isso pode envolver formatar os dados para um prompt de LLM (como no RAG), ou entregá-los a uma API, ou a um banco de dados vetorial que será consultado pelo modelo.

Para ilustrar como o ECL atua como uma evolução e um mapeamento dos princípios de ETL/ELT para o cenário dos LLMs, consideremos um exemplo prático: o uso de hierarquias de documentos para construir uma camada semântica rica.

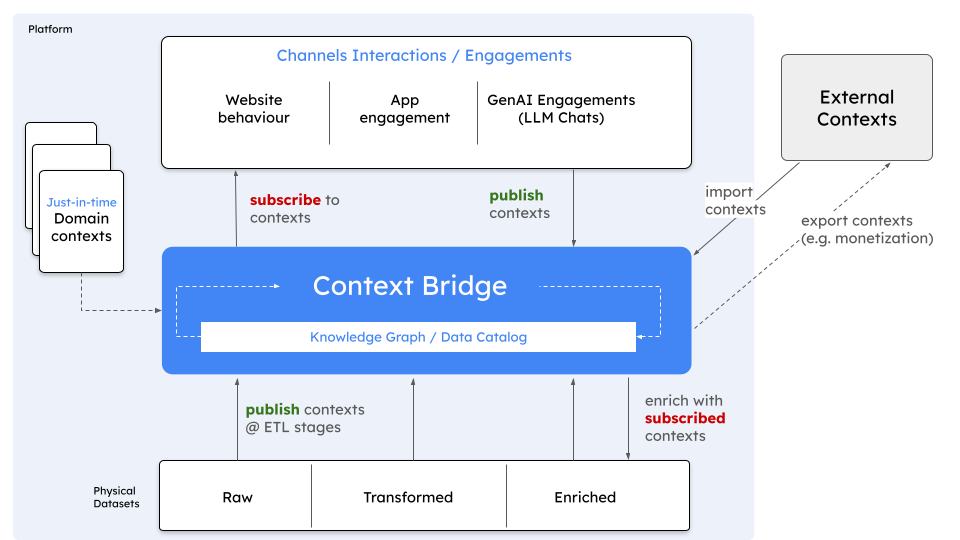

Nesse processo ECL, a etapa de Extração envolve a coleta de dados dos documentos originais (como manuais técnicos ou bases de conhecimento internas da sua empresa) e a sua divisão em partes menores ou 'chunks' textuais. Em seguida, a etapa de Contextualização é crucial: esses chunks não são apenas armazenados, mas enriquecidos com metadados e organizados em uma estrutura hierárquica ou relacionada. Essa informação contextualizada e estruturada é então armazenada, por exemplo, em um Grafo de Conhecimento (Knowledge Graph). O Grafo de Conhecimento resultante atua como uma poderosa camada semântica, representando as relações e o contexto das informações de forma explícita. Ele permite que as informações sejam recuperadas de forma muito mais precisa e contextual – navegando pela estrutura do grafo – antes mesmo de serem "carregadas" (Loading) no prompt de um LLM para gerar uma resposta. Em vez de apenas enviar texto cru ao LLM, enviamos texto ancorado em um contexto estruturado e navegável, otimizando significativamente a recuperação final da informação para o modelo.

O framework ECL (Extrair, Contextualizar e Carregar) emerge não como um substituto do ETL/ELT, mas como sua evolução lógica e necessária para a era da inteligência artificial contextual. Ele reconhece que simplesmente mover e transformar dados não é suficiente. É preciso ter um pipeline dedicado a extrair a informação certa, enriquecê-la profundamente com camadas de contexto – utilizando conhecimento especializado, regras de negócio e personalização.

Referências e leituras sobre este tema

Antes de você ir embora

Se quiser discutir mais sobre isso, fique à vontade para deixar um comentário ou entrar em contato comigo pelo LinkedIn.